2022年底,OpenAI推出的基于大语言模型(Large language model,LLM)的聊天机器人ChatGPT展示了令人印象深刻的强大能力,但大语言模型在临床应用的门槛很高。医学是一项人性化的事业,其中语言是临床医生、研究人员和患者之间的沟通互动的关键。人工智能(AI)模型,尤其是最近取得进展的大语言模型(Large language models,LLMs),为AI在医学领域的应用带来了新的希望。它们在医学领域有许多潜力,包括知识检索和支持临床决策。

这些AI模型虽然在一定程度上可用,但主要是单任务系统,缺乏表达能力和交互能力,还可能会编造令人信服的医疗错误信息,或纳入偏见加剧健康不平等。因此,现有的AI模型所能做的和在现实世界的临床工作流程中对它们的期望之间存在着不一致,使其难以转化为真实世界的可靠性或价值。

2023年7月12日,谷歌和谷歌旗下人工智能公司DeepMind的研究人员在国际顶尖学术期刊 Nature 上发表了题为:Large language models encode clinical knowledge 的研究论文。该研究展示了一个基准,用于评估大语言模型(LLM)能够多好回答医学问题,还介绍了一个专精医学领域的大语言模型——Med-PaLM。

大型语言模型(LLMs)的最新进展为重新思考人工智能系统提供了机会,语言是调解人类与人工智能交互的工具。大型语言模型作为“基础模型”,是经过预训练的大型人工智能系统,可以在众多领域和不同任务中以最小的努力重新调整用途。这些表达和交互的模型在从医学语料库中编码的知识中大规模学习普遍有用的表达方面提供了巨大的希望。这些模型在医学上有几个令人兴奋的潜在应用,包括知识检索、临床决策支持、关键发现总结、患者分诊、解决初级保健问题等等。

然而,该领域的安全关键性质需要经过深思熟虑的评估框架的开发,使研究人员能够有意义地衡量进展,并获取和减轻潜在的危害。这对大语言模型来说尤其重要,因为这些模型可能生成与临床和社会价值不一致的信息。例如,它们可能会生成令人信服的医疗错误信息,或者包含可能加剧健康不平等的偏见。

为评估大语言模型(LLM)编码临床医学知识的能力,研究团队探讨了它们回答医学问题的能力。这项任务非常具有挑战性,因为为医学问题提供高质量的答案需要理解医学背景,回忆适当的医学知识,并根据专家信息进行推理。

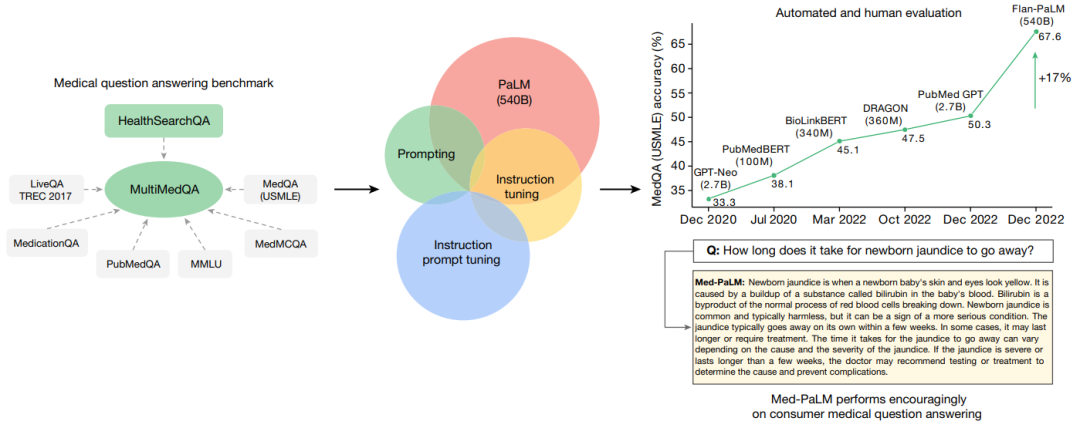

在这项研究中,提出了一个基准,称为MultiMedQA:它结合了6个涵盖专业医疗、研究和消费者查询的现有问题回答数据集以及HealthSearchQA——这是一个新的数据集,包含3173个在线搜索的医学问题。通过这一基准来评估大语言模型回答医学问题的真实性、在推理中使用专业知识、有用性、准确性、健康公平性和潜在危害。

表现令人鼓舞

研究团队随后评估了PaLM(5400亿参数的大语言模型)及其变体Flan-PaLM。他们发现,在一些数据集中Flan-PaLM达到了最先进水平的表现。在整合美国医师执照考试类问题的MedQA数据集中,Flan-PaLM超过此前最先进的大语言模型达17%,达到了67.6%的准确率,达到了通过考试的标准(60%)。不过,虽然FLAN-PaLM的多选题成绩优良,进一步评估显示,它在回答消费者的医疗问题方面存在差距。

为解决这一问题,研究团队使用一种称为设计指令微调(instruction prompt tuning)的方式进一步调试Flan-PaLM适应医学领域。设计指令微调是让通用大语音模型适用新的专业领域的一种有效方法。

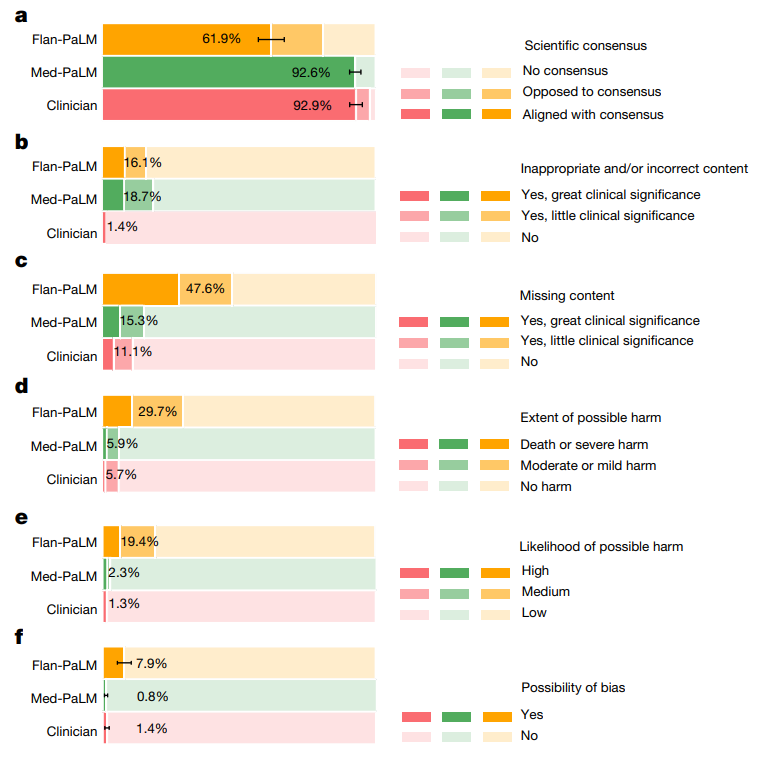

结果产生的新模型Med-PaLM在试行评估中表现令人鼓舞。例如,Flan-PaLM被一组医师评分与科学共识一致程度仅61.9%的长回答,Med-PaLM的回答评分为92.6%,相当于医师做出的回答(92.9%)。同样地,Flan-PaLM有29.7%的回答被评为可能导致有害结果,Med-PaLM仅5.9%,相当于医师所作回答(6.5%)。

升级版已推出

值得一提的是,这篇在 Nature 论文中描述的 Med-PaLM 模型于2022年12月推出,而在今年5月份,谷歌在预印本平台发表论文,推出了升级版的Med-PaLM 2。

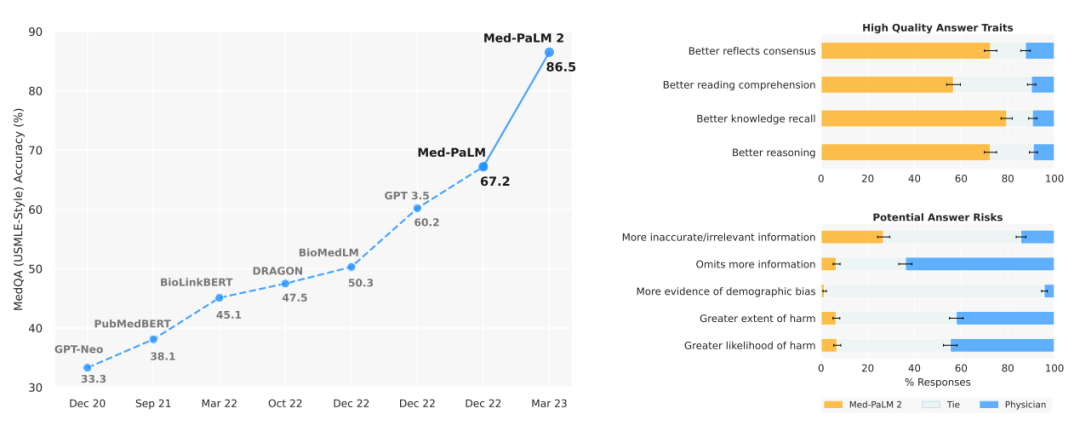

论文中显示,Med-PaLM 2是第一个在美国医疗执照考试(USMLE)类问题上达到专家级表现的大语言模型,能够正确回答多项选择题和开放式问题,并对答案进行推理,准确率高达86.5%,大幅超越了Med-PaLM以及GPT3.5。

Med-PaLM 2根据14项标准进行了测试,包括科学事实、准确性、医学共识、推理、偏见和危害,由来自不同背景和国家的临床医生和非临床医生进行评估。研究团队还发现该模型在回答医学问题方面仍存在一些差距,但并未具体说明,谷歌表示,进一步开发和改进该模型以解决这些差距,并了解大语言模型如何改善医疗保健。

已在梅奥医学中心开展临床测试

据报道,Med-PaLM 2目前正在世界顶尖的医疗机构梅奥医学中心进行初步试验。谷歌认为,这种模式在“看病机会有限”的国家尤其有用。他们还表示,在Med-PaLM 2试验期间提交的用户数据将被加密,谷歌无法访问,并由用户自己控制。

总的来说,Med-PaLM是一个强大的专精医学领域的大语言模型,而设计指令微调是一种有效的数据和参数校准技术,能够提高大语言模型的准确性、真实性、一致性、安全性,减少危害和偏差等因素,有助于缩小模型与临床专家的差距,使这些模型更接近现实世界的临床应用。

参考资料:

https://www.nature.com/articles/s41586-023-06291-2

https://arxiv.org/pdf/2305.09617.pdf

https://the-decoder.com/google-is-testing-its-generative-medical-language-model-in-a-clinical-setting/

Nature子刊:人工智能可以设计任何化合物的最佳合成路径?中山大学陈语谦团队提出一种端到端图生成架构用于逆合成预测

![]() 0

2023-05-28

点击查看

0

2023-05-28

点击查看

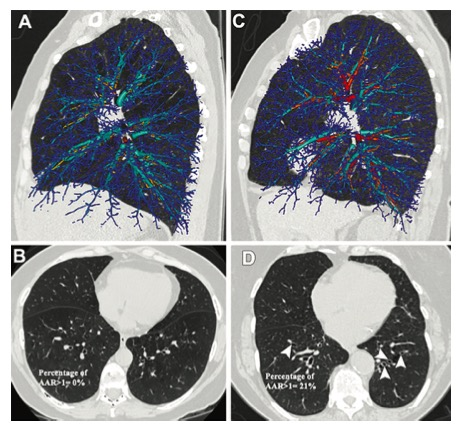

Radiology:基于CT人工智能的自动化支气管扩张评估

![]() 0

2023-06-10

点击查看

0

2023-06-10

点击查看

European Radiology:使用人工智能方法在TOF-MRA图像中实现脑动脉瘤的自动检测

![]() 0

2023-06-22

点击查看

0

2023-06-22

点击查看

「对话·心内」孙宁玲教授:人工智能时代,高血压远程管理正在进行中...

![]() 0

2023-06-14

点击查看

0

2023-06-14

点击查看

European Radiology:人工智能在低患病率健康筛查环境下的应用

![]() 0

2023-07-05

点击查看

0

2023-07-05

点击查看

梵蒂冈教皇发布AI指导,避免科技引发人类末日

![]() 0

2023-07-14

点击查看

0

2023-07-14

点击查看